最近发现一些公众号的图片资源还是可以利用一下的。本着能让机器干的活绝不能自己动手的原则,于是决定使用Python批量处理,让机器来处理一下。

实现思路

首先需要找到微信公众号的图片外链的共同特点,例如域名格式等。然后通过匹配这些特点的外链,识别出需要的图片资源。接着,遍历匹配到的外链,进行批量下载。

实现代码

import os

import re

import requests

from urllib.parse import urlparse, parse_qs

# 定义读取文件、匹配网址并保存文件的函数

def extract_and_save_urls(file_name, output_folder='下载图片素材'):

# 创建输出文件夹(如果不存在)

if not os.path.exists(output_folder):

os.makedirs(output_folder)

# 读取文件内容

with open(file_name, 'r', encoding='utf-8') as file:

content = file.read()

# 匹配网址的正则表达式

url_pattern = re.compile(r'https://mmbiz\.qpic\.cn/mmbiz_png/[^\s]+')

urls = url_pattern.findall(content)

# 下载并保存文件

for idx, url in enumerate(urls):

try:

response = requests.get(url)

if response.status_code == 200:

# 解析 URL 以获取文件扩展名

parsed_url = urlparse(url)

file_extension = parse_qs(parsed_url.query).get('wx_fmt', [''])[0]

if not file_extension: # 默认扩展名为 'png',如果未指定 wx_fmt 参数

file_extension = 'png'

file_name = f'image_{idx+1}.{file_extension}'

file_name = file_name.replace('"', '').replace(',', '').replace('?', '') # 移除不必要的字符

file_path = os.path.join(output_folder, file_name)

with open(file_path, 'wb') as img_file:

img_file.write(response.content)

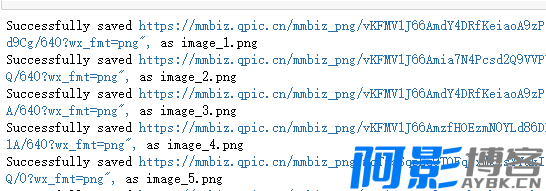

print(f'Successfully saved {url} as {file_name}')

else:

print(f'Failed to download {url}, status code: {response.status_code}')

except Exception as e:

print(f'Error downloading {url}: {e}')

# 指定输入输出文件

file_name = 'data.js'

extract_and_save_urls(file_name)

扩展

目前脚本只实现了对png格式图片的下载,可以扩展到其他格式如jpg、gif、jpeg等图片资源的匹配和下载。另外,目前脚本只能对指定的文件进行下载,可以增加支持读取整个目录下文件的功能。此外,微信公众号上不仅有图片资源,还有音频资源,可以进一步扩展脚本以支持下载公众号上的音频资源。

以上是关于使用Python批量处理微信公众号图片资源的实现思路。

隐藏内容

附件需要 登录 后就可下载!

免费声明

- 本网站的文章内容可能来源于网络,仅供大家学习与参考,如有侵权,请联系站长QQ:304906607进行删除处理。

- 文章采用: 《署名-非商业性使用-相同方式共享 4.0 国际 (CC BY-NC-SA 4.0)。

- 本站资源大多存储在云盘,如发现链接失效,请联系我们我们会第一时间更新。

- 本站一切资源不代表本站立场,并不代表本站赞同其观点和对其真实性负责。

- 本站一律禁止以任何方式发布或转载任何违法的相关信息,访客发现请向站长举报

- 本站永久网址:https://www.aybk.cn

PHP怎么实现微信小程序内容安全识别接口?

« 上一篇

07-13

情侣小窝 Like_Girl源码V5.1.1

下一篇 »

07-13

发表评论

请先登录后才能发表评论